Scikit-learnは、Pythonで広く使用されている機械学習ライブラリであり、多くの機械学習アルゴリズムの実装を提供しています。

その中でも、線形回帰は最も基本的でありながら強力なツールの一つです。

線形回帰の基本的な概念とScikit-learnを使用したその実装について詳しく説明しましょう。

目次

線形回帰の基本

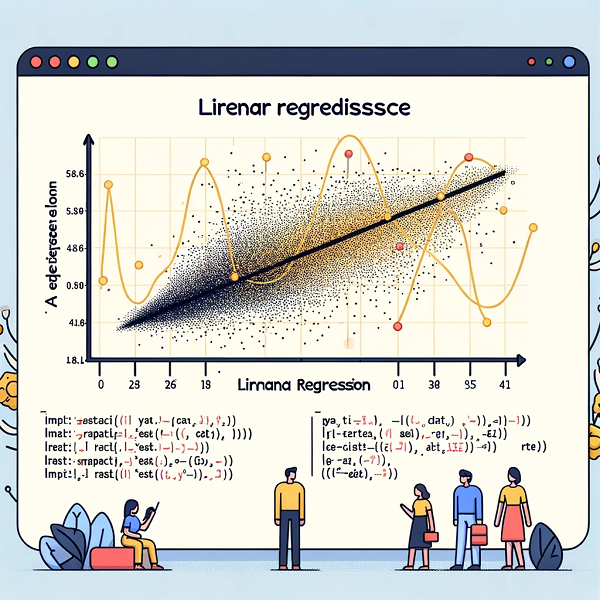

線形回帰は、与えられたデータセットを最もよく表す直線(または平面、あるいは超平面)を見つけることを目的とする統計的手法です。

基本的には、ある変数(目的変数、通常は y と表される)が他の一つまたは複数の変数(説明変数、x と表される)にどのように依存しているかをモデル化します。

Scikit-learnにおける線形回帰の実装

Scikit-learnでは、線形回帰は LinearRegression クラスを通じて簡単に実装できます。

基本的なステップは以下の通りです。

- インポートとデータの準備:

Scikit-learnのLinearRegressionクラスをインポートし、回帰モデルに適合させるためのデータを準備します。 - モデルの作成:

LinearRegressionクラスのインスタンスを作成します。 - モデルの適合:

.fit()メソッドを使用して、データにモデルを適合させます。このステップでは、モデルがデータから回帰係数を学習します。 - 予測:

学習したモデルを使用して、新しいデータポイントに対する予測を行います。これは.predict()メソッドによって行われます。 - 評価:

モデルの性能を評価するために、様々な指標(例えば、平均二乗誤差)を計算します。

サンプルコード

PythonでScikit-learnを使用した線形回帰の基本的な実装例を以下に示します。

from sklearn.linear_model import LinearRegression

from sklearn.model_selection import train_test_split

from sklearn.metrics import mean_squared_error

import numpy as np

# 仮のデータ

X = np.random.rand(100, 1) # 説明変数

y = 2 * X + 1 + np.random.randn(100, 1) * 0.5 # 目的変数

# データを訓練セットとテストセットに分割

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

# モデルの作成

model = LinearRegression()

# モデルの訓練

model.fit(X_train, y_train)

# モデルを使った予測

y_pred = model

.predict(X_test)

# モデルの評価

mse = mean_squared_error(y_test, y_pred)

print("平均二乗誤差:", mse)このコードは、ランダムに生成されたデータセットに対して線形回帰モデルを適用し、その性能を評価する基本的な例です。

実際のアプリケーションでは、より複雑なデータセットと事前処理、特徴量の選択、モデルの微調整などを考慮する必要があります。

以上、Scikit-learnの線形回帰についてでした。

最後までお読みいただき、ありがとうございました。