ディープラーニングのニューラルネットワークについての詳細な解説を行います。

この分野は、人工知能(AI)の進化において非常に重要な役割を果たしており、現代のテクノロジーに大きな影響を与えています。

目次

ニューラルネットワークの基本

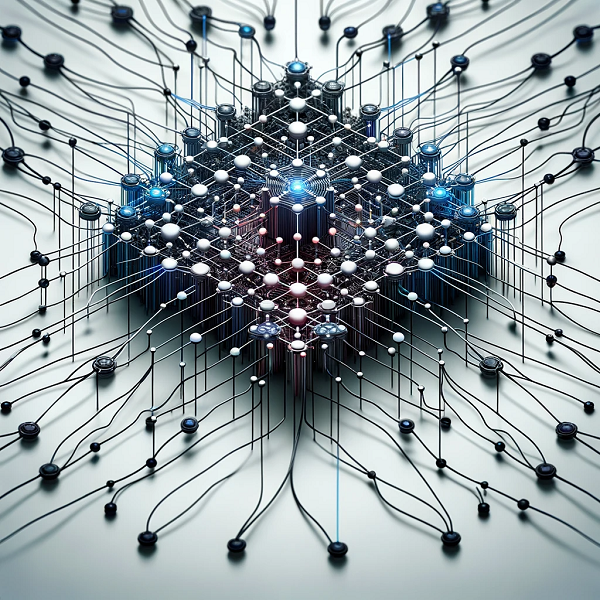

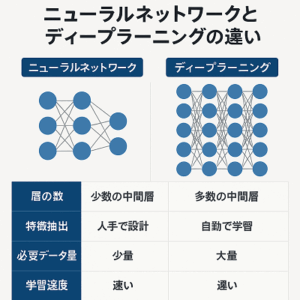

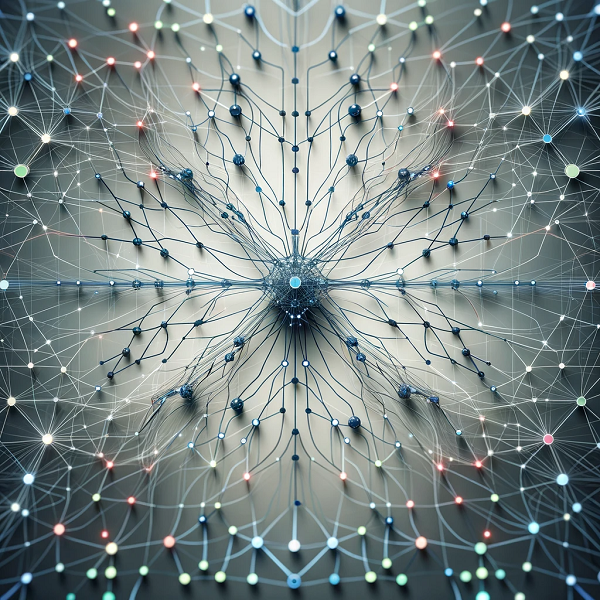

ニューラルネットワークは、ディープラーニングや機械学習における基本的な概念であり、人間の脳のニューロンのネットワークに触発されて作られました。

この技術は、データからパターンを学習し、予測や分類などの複雑なタスクを実行するために広く使用されています。

各層は、多数の「ニューロン」と呼ばれる処理ユニットで構成され、これらが互いに接続されています。

ニューラルネットワークの基本構造

ニューロン(ノード)

- 概要: ニューロンは、入力信号を受け取り、加工して出力する基本的な単位です。

- 動作: 各ニューロンは、複数の入力を受け取り、これらの入力に重みを掛け合わせ、合計値を計算します。この合計値にバイアスを加えた後、活性化関数を通して出力を生成します。

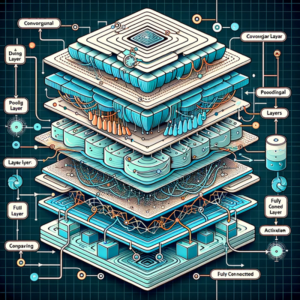

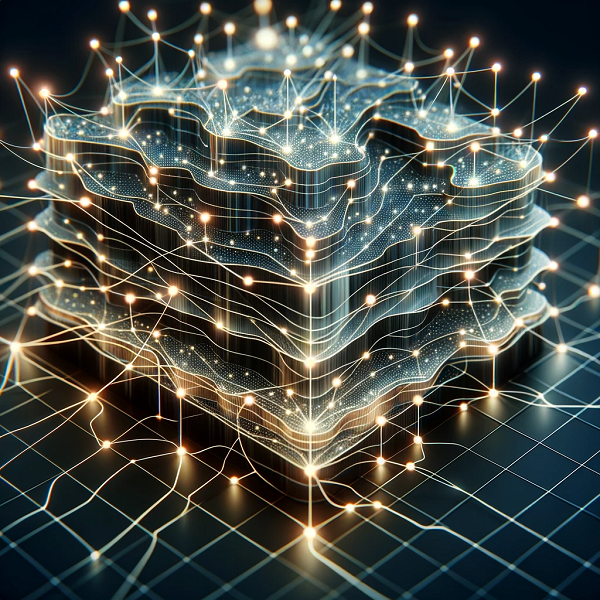

層(Layer)

- 入力層(Input Layer): ネットワークへの入力を受け取る最初の層。

- 隠れ層(Hidden Layers): 入力層と出力層の間にある一つまたは複数の層。データの複雑な特徴を学習。

- 出力層(Output Layer): 最終的な予測や分類結果を出力する層。

重み(Weights)とバイアス(Biases)

- 重み: 入力信号の重要性を調節するパラメータ。

- バイアス: ニューロンの出力を微調整する追加的なパラメータ。

ニューラルネットワークの学習プロセス

順伝播(Forward Propagation)

- データは入力層から出力層へと順に処理されます。

- 各層のニューロンは、前の層からの出力を入力として受け取り、重みとバイアスを使って処理します。

損失関数(Loss Function)

- ネットワークの予測と実際のラベルとの間の誤差を測定します。

- 例: 二乗誤差、交差エントロピー。

逆誤差伝播(Backpropagation)

- 損失関数の勾配を使用して、ネットワークを通じてエラーを逆方向に伝播させ、重みとバイアスを更新します。

最適化アルゴリズム(Optimization Algorithm)

- 学習プロセスを通じて、重みとバイアスを最適化します。

- 例: 勾配降下法(Gradient Descent)、Adam最適化アルゴリズム。

ニューラルネットワークの種類

- フィードフォワードニューラルネットワーク(FFNN)

- 最も基本的な形式。データが一方向に流れる。

- 畳み込みニューラルネットワーク(CNN)

- 主に画像処理に使用。局所的な接続と共有重みを特徴とする。

- リカレントニューラルネットワーク(RNN)

- 時系列データや順序が重要なデータに適用。過去の情報を保持する能力を持つ。

- 生成的敵対ネットワーク(GAN)

- 二つのネットワーク(生成器と識別器)が対抗しながら学習。新しいデータの生成に使用。

- 自己符号化器(Autoencoders)

- 入力を圧縮し、その後それを再構築することを学習。データの次元削減や特徴学習に用いられる。

まとめ

ディープラーニングのニューラルネットワークは、複数の層を持ち、データの複雑な特徴を学習することができます。

画像認識、自然言語処理、音声認識など多岐にわたる分野で応用されており、今後もAIの進化に不可欠な技術となっています。

ただし、高い計算資源の要求やモデルの解釈性の問題など、解決すべき課題も残されています。

以上、ディープラーニングのニューラルネットワークについてでした。

最後までお読みいただき、ありがとうございました。