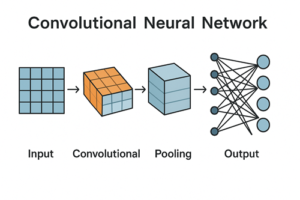

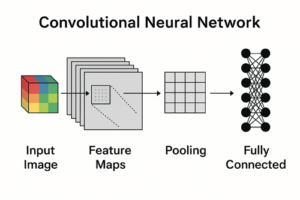

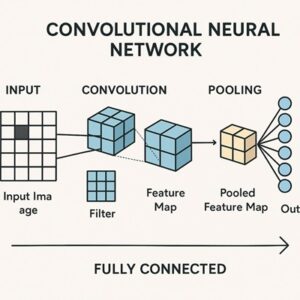

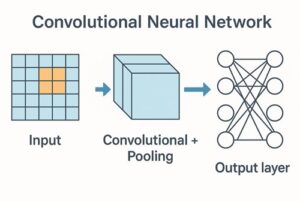

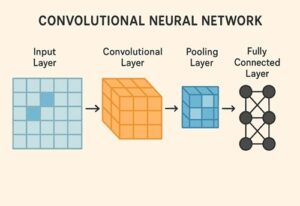

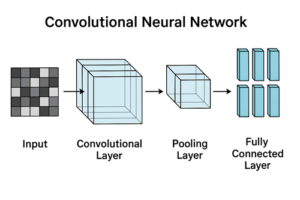

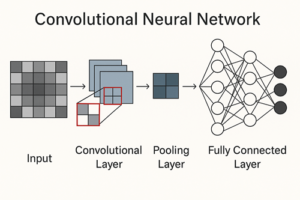

CNN(畳み込みニューラルネットワーク)におけるプーリング層(Pooling Layer)は、畳み込み層によって抽出された特徴マップを空間的に要約し、モデルの安定性や計算効率を高めるために用いられる重要な構成要素です。

単に「画像サイズを小さくする処理」と思われがちですが、実際には特徴表現の汎化、ノイズの抑制、過学習の軽減など、複数の役割を担っています。

プーリング層の基本的な役割

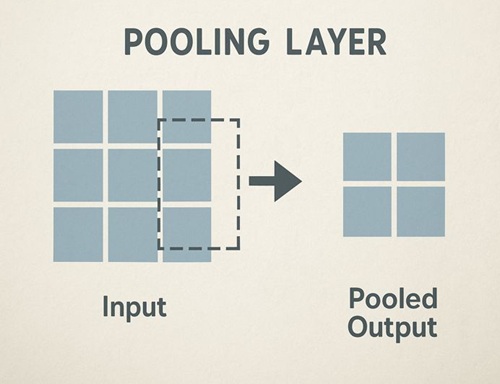

プーリング層は、特徴マップ上の一定領域(ウィンドウ)ごとに代表値を計算し、空間解像度を下げる処理を行います。

主な目的は次のとおりです。

- 特徴マップのダウンサンプリング

- 局所的な位置ズレに対する頑健性の向上

- 計算量およびメモリ使用量の削減

- 過学習の抑制

特に重要なのは、プーリング層は特徴の有無を重視し、正確な位置情報をある程度捨てる設計になっているという点です。

なぜプーリング層が必要なのか

局所的な位置ズレに対する頑健性

画像中のエッジや角といった特徴は、数ピクセル程度位置がずれても同じ意味を持つ場合が多くあります。

プーリング層では、局所領域内の代表値を用いることで、小さな平行移動に対して安定した特徴表現を得やすくなります。

ただし、これはあくまで局所的な頑健性であり、プーリング層だけで完全な平行移動不変性が得られるわけではありません。

計算量の削減と深層化の実現

一般的な 2×2、ストライド 2 のプーリングでは、特徴マップの縦横サイズがそれぞれ半分になります。

その結果、次の畳み込み層における主要な計算量(空間サイズに比例する部分)は、おおよそ 1/4 程度に削減されます。

この効果により、CNNは計算コストを抑えながら、より深い構造を持つモデルを構築できるようになります。

代表的なプーリング手法

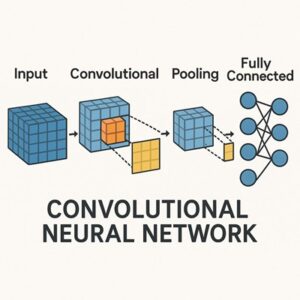

Max Pooling(最大値プーリング)

Max Poolingは、ウィンドウ内の最大値を出力する方式で、最も広く使われています。

- 強い活性を持つ特徴を残しやすい

- エッジやコーナーなどの検出と相性が良い

- ノイズに比較的強い

画像分類タスクでは、初期層から中間層にかけて標準的に使用されることが多い手法です。

Average Pooling(平均値プーリング)

Average Poolingは、ウィンドウ内の平均値を出力する方式です。

- 特徴を滑らかに要約します

- 情報を広く保持する一方で、特徴が弱まりやすい傾向があります

中間層ではMax Poolingほど一般的ではありませんが、設計方針やタスクによっては使用されることもあります。

また、後述するGlobal Average Poolingでは重要な役割を果たします。

Global Average Pooling(GAP)

Global Average Pooling(GAP)は、特徴マップ全体を平均し、各チャネルを1つの値に集約する手法です。

- 全結合層の代替として用いられます

- パラメータ数を大幅に削減できます

- 過学習を抑制しやすくなります

ResNetやMobileNetなど、現代の画像分類向けCNNでは事実上の標準的な構成となっています。

プーリング層の主なハイパーパラメータ

プーリング層では、主に次のハイパーパラメータを設定します。

- カーネルサイズ:一般的には

2×2が用いられます - ストライド:多くの場合、カーネルサイズと同じ値が設定されます

- パディング:基本的には不要ですが、出力サイズを調整したい場合に使用されることがあります

プーリング層のメリットとデメリット

メリット

- 計算コストを削減できます

- 汎化性能の向上が期待できます

- ノイズに強い特徴表現を得られます

デメリット

- 情報が不可逆的に失われます

- 正確な空間情報を保持しにくくなります

- 小さな物体や細かな特徴の識別には不利です

プーリングを使わない設計との関係

近年のCNNでは、プーリング層の代わりにストライド付き畳み込み(Strided Convolution)を用いてダウンサンプリングを行う設計も増えています。

- 学習可能なパラメータを持つため柔軟に表現できます

- 計算量はやや増加します

- 情報保持の度合いを調整しやすくなります

そのため現在では、プーリング層を使うかどうかではなく、タスクに応じて適切に使い分ける設計思想が主流となっています。

まとめ

プーリング層は、CNNにおいて

- 特徴表現を安定させ

- 計算効率を高め

- モデルの汎化性能を向上させる

ための重要な要素です。

一方で、情報損失という明確なトレードオフも存在するため、プーリング層の役割と特性を理解したうえで、適切な位置と方法で使用することが重要です。

以上、CNNのプーリング層についてでした。

最後までお読みいただき、ありがとうございました。