深層学習で頻繁に登場するCNN(畳み込みニューラルネットワーク)とRNN(再帰型ニューラルネットワーク)は、同じニューラルネットワークでありながら、想定しているデータの構造と情報の扱い方が根本的に異なります。

この違いを理解することは、モデル選定の精度を大きく左右します。

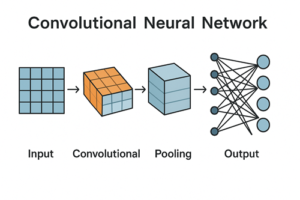

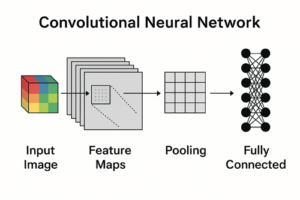

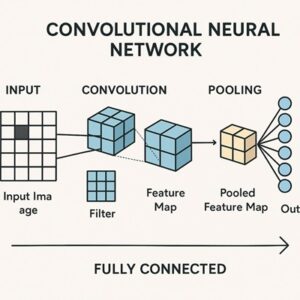

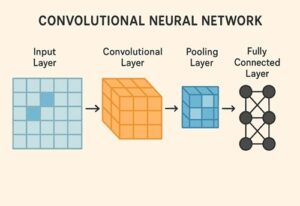

CNN(畳み込みニューラルネットワーク)の特徴

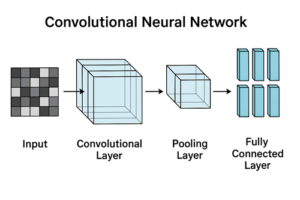

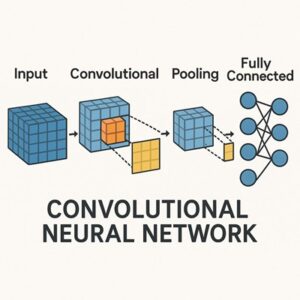

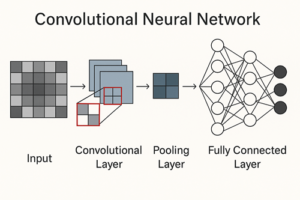

CNNは、空間的な構造を持つデータを効率よく処理するために設計されたモデルです。

画像のように、隣り合う要素同士が意味的に関連しているデータを想定しています。

CNNの大きな特徴は、同じ処理をデータ全体に繰り返し適用する設計にあります。

この仕組みによって、特定の特徴がデータのどの位置に現れても検出しやすくなります。

その結果、入力の位置が多少変わっても、同様の特徴を捉えられる傾向があります。

ただし、位置に完全に依存しなくなるかどうかは、ネットワーク構成や学習方法に依存します。

また、CNNは入力データの局所的な情報を段階的に組み合わせることで、より抽象度の高い特徴を学習します。

浅い層では単純なパターンを、深い層ではより複雑な構造を捉える、という階層的な表現が可能です。

一方で、CNNはRNNのように「過去の入力を内部状態として保持し続ける」仕組みを基本的には持ちません。

そのため、時系列データを逐次的に記憶しながら処理する用途には向いていないケースがあります。

ただし、設計次第では時系列データにも十分対応可能です。

RNN(再帰型ニューラルネットワーク)の特徴

RNNは、順序や時間の流れが意味を持つデータを扱うことを目的としたモデルです。

文章、音声、時系列データなど、「前に何が来たか」が重要になる場面で力を発揮します。

RNNの最大の特徴は、過去の情報を内部状態として保持し、次の処理に反映する点です。

これにより、現在の判断が直前までの文脈に基づいて行われます。

文章理解や時系列予測に向いている理由はここにあります。

ただし、RNNは構造上、入力を順番に処理する必要があるため、時間方向の並列処理が難しいという制約があります。

この点は、大規模データや長い系列を扱う場合に計算効率の面で不利になることがあります。

また、単純なRNNは学習が不安定になりやすいという課題がありました。

この問題を緩和するために、内部状態の扱いを工夫した派生モデルが広く使われるようになっています。

CNNとRNNの本質的な違い

CNNとRNNの違いは、単に「画像向き」「時系列向き」という表面的な分類にとどまりません。

本質的には、どのような依存関係をモデルが前提としているかが異なります。

CNNは、近くにある情報同士の関係性を重視します。

入力全体を一度に見渡すというよりも、小さな領域から特徴を積み上げていく考え方です。

一方、RNNは、過去から現在へと続く順序関係を重視します。

情報は時間の流れに沿って蓄積され、現在の出力に影響を与えます。

また、計算の進め方にも違いがあります。CNNは比較的並列処理に向いており、高速に学習・推論が可能です。

RNNは構造上、順番処理が必要になるため、処理速度やスケーラビリティに制約が生じやすくなります。

実務における使い分けの考え方

実務でCNNとRNNを選ぶ際は、「データの見た目」ではなく、意味の依存関係がどこにあるかを基準に考えることが重要です。

- 入力内の位置関係や局所的なパターンが重要な場合はCNNが適しています。

- 過去の情報が現在の判断に影響する場合はRNNが有力な選択肢になります。

近年では、これらを組み合わせた構成や、別のアーキテクチャが採用されることも多くなっています。

そのため、CNNとRNNは「どちらが優れているか」ではなく、どの問題にどの構造が合っているかという観点で理解することが重要です。

まとめ

CNNは、空間構造や局所的特徴の抽出に強いモデルであり、並列処理しやすいという利点があります。

RNNは、順序や時間的文脈を内部状態として保持できる点が最大の特徴です。

両者は目的が異なる設計思想に基づいており、扱うデータの性質に応じて使い分けることで、モデルの性能と実用性を最大化できます。

以上、CNNとRNNの違いについてでした。

最後までお読みいただき、ありがとうございました。