CNN(畳み込みニューラルネットワーク)の層数設計は、「経験則だけで決めると失敗しやすいが、理論だけでも決めきれない」という難しさがあります。

本記事では、誤解されやすいポイントを修正しながら、実務で再現性の高い考え方に整理して解説します。

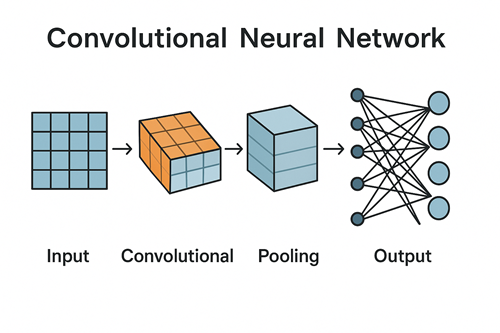

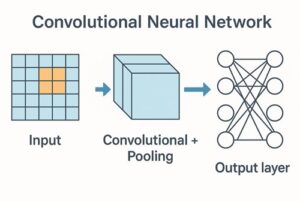

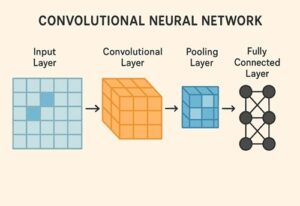

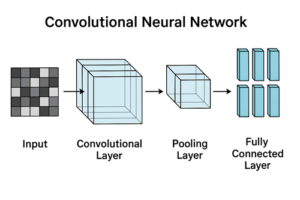

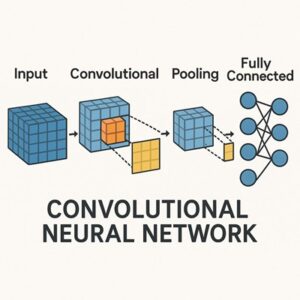

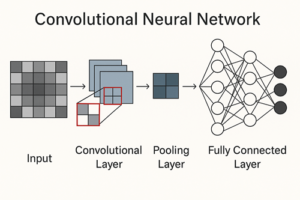

CNNにおける「層数」とは何を指すのか

まず前提として、CNNの「層数」は文脈によって意味が変わります。

- 畳み込み層(Convolution Layer)の数

- Conv+BN+ReLU などをまとめたブロック数

- 全結合層を含めた総層数

- ResNetのようなResidual Blockを1層と数えるかどうか

実務で議論されることが多いのは、

畳み込み層、または畳み込みブロックの深さ

です。

なお、ResNet18 / 50 などの数字も、「何を1層と数えるか」は論文や実装によって多少の揺れがあります。

そのため 層数そのものを絶対値として比較するのは適切ではない、という点は常に意識する必要があります。

なぜ層数が重要なのか(基本的な考え方)

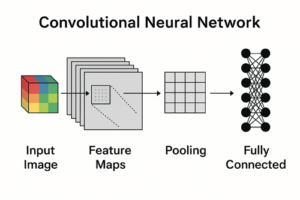

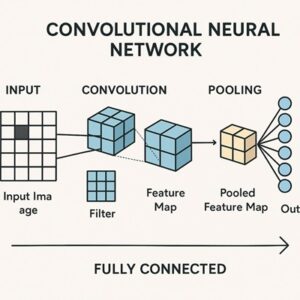

CNNは階層的に特徴を学習する

CNNは一般に、層が深くなるにつれて抽象度の高い特徴を学習します。

- 浅い層:エッジ、線、角などの局所的特徴

- 中間層:模様、テクスチャ、パーツ

- 深い層:物体や意味的な構造

これはあくまで傾向であり、データセットやアーキテクチャによって例外もありますが、「層数=表現できる抽象度の深さ」という理解は現在でも有効です。

層数が少なすぎる場合

- 表現力が不足し、複雑なパターンを捉えられない

- 学習誤差・検証誤差ともに下がらない(アンダーフィッティング)

層数が多すぎる場合

- 過学習のリスク増大

- 学習時間・計算コストの増加

- 設計やハイパーパラメータ調整が難しくなる

なお、近年は Batch Normalization や Residual Connection により、「深い=学習不能」ではなくなっている点も重要です。

層数を決めるための主要な判断軸

タスクの性質・難易度

| タスク例 | 一般的な傾向 |

|---|---|

| 手書き数字認識 | 浅いモデルで十分 |

| 小規模物体分類 | 中程度の深さ |

| 高度な物体認識 | 深いモデルが有利 |

単純な形状認識では深さは不要ですが、意味理解に近づくほど深さの恩恵が出やすくなります。

入力画像の解像度

高解像度画像では、空間サイズを段階的に縮小する必要があります。

- その結果として 層が深くなりやすい

- ただし、strideを大きく取る・初段で強くダウンサンプリングするなど、

必ずしも層数を増やす必要はない設計も可能

重要なのは「層数」そのものより、どのように解像度を落としていくかです。

データ量(特にスクラッチ学習かどうか)

ここは非常に重要なポイントです。

- スクラッチ学習 × データ少

→ 深いCNNは過学習しやすい - 転移学習あり × データ少

→ むしろ深い事前学習モデルが有利な場合が多い

したがって、

「データが少ないから深いモデルはダメ」

というのは不正確で、正しくは

「スクラッチで学習する場合、データ量に対して深すぎるモデルは危険」

となります。

アーキテクチャと正則化手法

以下があるほど、深いモデルを安定して使えます。

- Batch Normalization

- Residual Connection(ResNet系)

- 適切な初期化(He初期化など)

- Data Augmentation

- Weight Decay / Dropout / Label Smoothing

特に Residual Connection の有無は、「設計可能な深さの範囲」を大きく広げます。

計算資源・推論速度の制約

実務では性能だけでなく、

- 推論レイテンシ

- GPU / CPU / モバイル端末対応

- メモリ使用量

も重要です。

そのため「精度が少し下がっても軽量モデルを選ぶ」判断も十分に合理的です。

実務で現実的な層数の決め方

方法①:既存のバックボーンを基準にする(最も堅実)

ゼロから層数を決めるよりも、

- ResNet18 / 34 / 50

- MobileNet

- EfficientNet

- ConvNeXt 系

など、実績のあるモデルを起点にする方が失敗が少なくなります。

方法②:まず浅め → 足りなければ拡張

- 軽めのモデルで学習

- 学習曲線を確認

- アンダーフィットなら容量を増やす

(深さだけでなく幅・解像度・正則化も含めて検討)

この反復が最も実務的です。

方法③:Convブロック単位で考える

層を1枚ずつ考えるより、

[Conv + BN + ReLU] × N

→ Downsampleという ブロック単位で深さを調整する方が設計しやすくなります。

層数の目安についての正しい捉え方

「◯層が正解」という絶対的な基準はありません。

- 小規模タスク:浅いモデルで十分な場合が多い

- 中〜大規模タスク:深い事前学習モデルが主流

- 重要なのは 深さ単体ではなくモデル全体の容量と設計

層数はあくまで調整ノブの一つです。

結論:CNNの層数はこう考える

- 層数は「多いほど良い」わけではない

- 転移学習が使えるかどうかが最大の分岐点

- まずは 既存モデルを基準にする

- 深さだけでなく 幅・正則化・ダウンサンプリング設計も同時に考える

最終的には、

「データ条件と制約の中で、最も安定して性能が出る構成」

を選ぶことが、正しい層数設計と言えます。

以上、CNNの層数の決め方についてでした。

最後までお読みいただき、ありがとうございました。