人工知能(AI)の分野では、「ニューラルネットワーク」と「ディープラーニング」という言葉がしばしば混同されます。

しかし、両者は同じではありません。関係性を簡単に言えば、ディープラーニングはニューラルネットワークの発展形です。

ここでは、その構造・仕組み・歴史・応用分野までを、正確かつ分かりやすく解説します。

ニューラルネットワークとは?

基本概念

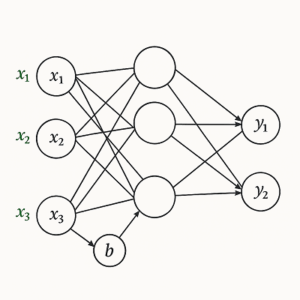

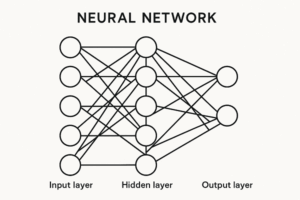

ニューラルネットワーク(Neural Network)は、人間の脳内で情報を伝達する「ニューロン(神経細胞)」の働きを数学的に模倣したモデルです。

入力されたデータを複数の層を通して処理し、最終的に出力を得ることで、分類・予測・パターン認識などを行います。

基本構造

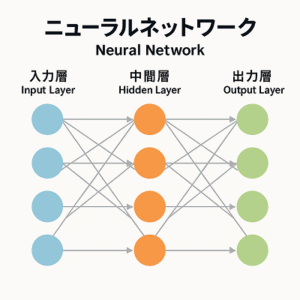

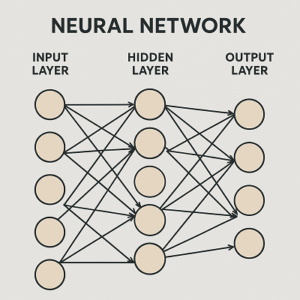

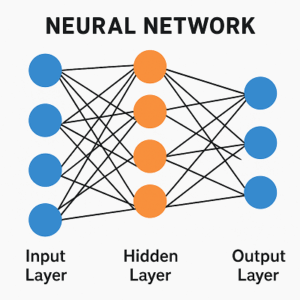

ニューラルネットワークは主に次の3層で構成されます。

- 入力層(Input Layer)

入力データを受け取る層。画像ならピクセル値、テキストなら単語ベクトルなど。 - 中間層(Hidden Layer)

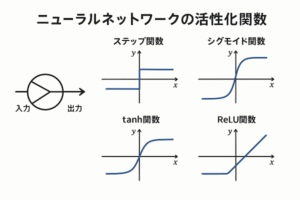

入力データを加工し、特徴を抽出する層。活性化関数(ReLUやSigmoidなど)を使って非線形な変換を行います。 - 出力層(Output Layer)

最終的な結果を出力する層。分類タスクでは確率、回帰タスクでは数値を出します。

特徴と限界

初期のニューラルネットワークは中間層が1〜2層の「浅い構造(Shallow Network)」が主流でした。

そのため複雑なデータパターンを扱う能力が限定的で、画像や音声など高次元データの理解には不十分でした。

ディープラーニングとは?

定義と特徴

ディープラーニング(Deep Learning)は、多数の中間層(多層構造)を持つニューラルネットワークを指します。

「ディープ(深い)」という言葉は、層の多さを意味しますが、「何層以上」といった厳密な定義は存在しません。

一般的には5層以上〜数百層にも及ぶ構造を指します。

この深い層構造により、従来の機械学習で人間が手作業で設計していた特徴抽出(Feature Engineering)を、モデル自身が自動的に学習することが可能になりました。

これを「表現学習(Representation Learning)」と呼びます。

主なアーキテクチャ

ディープラーニングには、用途に応じてさまざまな構造があります。

- CNN(Convolutional Neural Network):画像認識に特化。局所特徴を畳み込み処理で抽出。

- RNN / LSTM(Recurrent Neural Network / Long Short-Term Memory):時系列や音声など、順序のあるデータを処理。

- Transformer:自己注意機構を用い、大量データを効率的に学習。ChatGPTなどの言語モデルの基盤。

現在では、Transformer系のモデルが画像・音声・テキストの多領域で主流となっています。

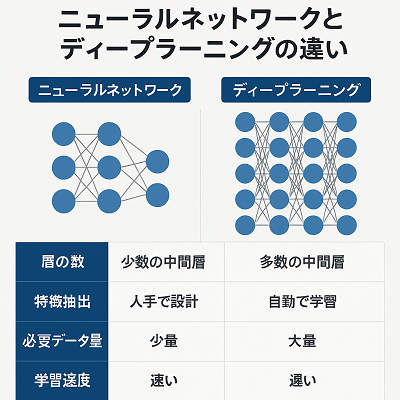

両者の違い(構造・処理・特徴の比較)

| 比較項目 | ニューラルネットワーク | ディープラーニング |

|---|---|---|

| 層の深さ | 少数の中間層(浅い) | 多数の中間層(深い) |

| 特徴抽出 | 人手で設計が必要 | 自動で特徴を学習(表現学習) |

| 必要データ量 | 少〜中規模で可 | 大量データが必要(ただし転移学習で軽減可能) |

| 計算リソース | CPUで実行可能 | 学習にGPU/TPUが必須(推論は最適化で軽量化可能) |

| 学習速度 | 比較的高速 | 訓練は重いが、推論は最適化で高速化可能 |

| 応用範囲 | 単純な分類や回帰 | 画像認識、音声、自然言語、生成AIなど高次タスク |

学習の仕組みと技術的背景

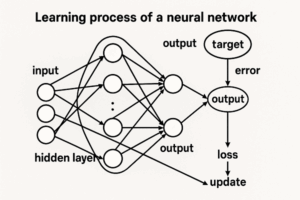

ディープラーニングを可能にしたのは、次の3要素です。

- 大規模データ(Big Data)

SNSやIoTの普及で膨大なデータが利用可能に。 - 高性能なGPU・TPU

膨大な計算を高速に処理できるハードウェアの進化。 - 学習アルゴリズムの改善

誤差逆伝播法(Backpropagation)の改良、Batch NormalizationやAdam最適化手法などが学習の安定化に貢献。

さらに現在は、事前学習済みモデル(Pretrained Model)と転移学習(Transfer Learning)が一般化し、限られたデータでも高精度なモデル構築が可能になっています。

歴史的な進化の流れ

| 年代 | 主な出来事 | 意義 |

|---|---|---|

| 1950〜60年代 | パーセプトロン登場(Rosenblatt) | ニューラルネットワークの原型 |

| 1986年 | 誤差逆伝播法(Rumelhartら) | 多層ネットワークの学習が可能に |

| 1989年 | LeCunらが手書き数字認識(CNN) | 実用的NNの礎を築く |

| 2006年 | Hintonらが深層事前学習を提案 | ディープラーニングの再興 |

| 2012年 | AlexNetがImageNetで圧勝 | GPU活用でDLブーム到来 |

| 2015年 | ResNet登場 | 非常に深いネットワークが安定して学習可能に |

| 2017年 | Transformer登場 | 自然言語処理の革命。LLM時代の幕開け |

応用分野の違いと使い分け

ニューラルネットワークが有効な領域

- センサー信号や制御システム

- 簡易な分類・回帰分析

- データ規模が小さい問題設定

ディープラーニングが強い領域

- 画像認識(医療画像診断、顔認識)

- 音声認識・音声合成(Siri, Alexaなど)

- 自然言語処理(ChatGPT, BERTなど)

- 生成AI(Stable Diffusion、音楽生成など)

現代AIとの関係

ChatGPTなどの大規模言語モデル(LLM)は、ディープラーニングの中でも特にTransformer構造を用いた発展形です。

「自己注意(Self-Attention)」という仕組みにより、大量のテキストから文脈を理解し、人間のような文章生成を可能にしています。

このように、ディープラーニングは“知能を生み出す基盤技術”へと進化しました。

まとめ:両者の関係性を一言で言うなら

ニューラルネットワークは「仕組み」であり、ディープラーニングはその「進化形の実践技術」です。

すべてのディープラーニングはニューラルネットワークに基づきますが、すべてのニューラルネットワークがディープラーニングとは限りません。

深層構造と膨大なデータを駆使して高度な表現学習を行うことで、ディープラーニングは現代AIの中心的技術となっています。

以上、ニューラルネットワークとディープラーニングの違いについてでした。

最後までお読みいただき、ありがとうございました。