BERT(Bidirectional Encoder Representations from Transformers)は、自然言語処理における大規模事前学習モデルの代表格であり、文章の文脈を前後方向から同時に捉える能力を持つ点に特徴があります。

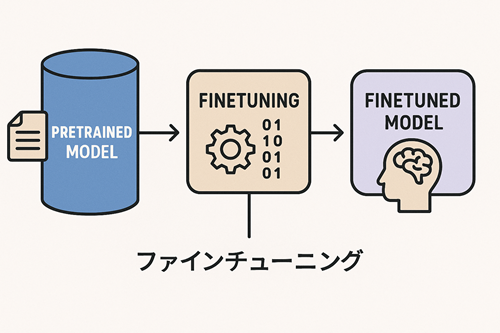

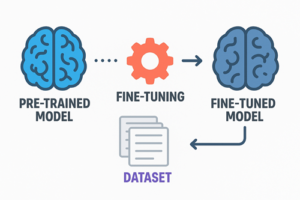

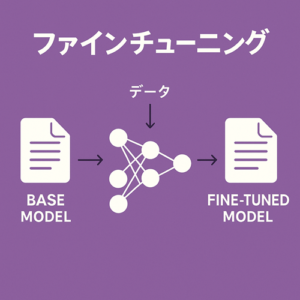

事前学習によって言語一般の知識を獲得しているため、特定タスクに最適化するには微調整(ファインチューニング)が必須となります。

本稿では、BERTの構造、ファインチューニングの考え方、効果的に学習させるための実務的な観点や理論的背景を、体系的に整理して解説します。

なぜBERTにはファインチューニングが必要なのか

BERTは、膨大なコーパスを使って「隠された単語を予測する(Masked Language Modeling)」や「2文が連続しているかを判断する(Next Sentence Prediction)」といった学習を事前に行うことで、一般的な言語パターンを獲得しています。

しかし、これはあくまで“汎用的な知識”であり、特定のタスクに最適化されたものではありません。

例えば、分類・固有表現抽出・質問応答・自然言語推論など、下流タスクそれぞれが必要とする判断基準は異なります。

そのため、BERTを基盤として、その上にタスク固有の層を追加し、自身のデータセットに合わせて追加学習を行う必要があります。

ファインチューニングの基本構造

BERTの事前学習済みモデルのトップに、タスクに対応した小規模な層(分類層、スパン抽出層など)を設置し、全体を通して再学習するのが基本的な流れです。

一般に、モデルは以下の構造をとります。

- エンベッディング層(トークン埋め込み・位置埋め込み)

- Transformerエンコーダ層(12層 or 24層)

- [CLS] トークンに基づく特徴量抽出

- タスク特化ヘッド(全結合層など)

ファインチューニングでは、これらのパラメータの一部または全部を更新します。

効果的なファインチューニングのための学習設定

BERTを安定的に微調整するには、ハイパーパラメータの設定が非常に重要です。

特に、学習率や学習範囲の選択はモデルの性能に大きく影響します。

学習率の推奨範囲

BERTは非常に繊細なモデルであり、過度に高い学習率を与えると急激に性能が劣化します。

一般的には次のような低い値が推奨されます。

- 2e-5 ~ 5e-5

微調整とはいえ、すでに学習済みの重みを破壊しないよう細かく更新していく必要があるためです。

エポック数は短めに設定する

BERTはすでに事前学習により十分な言語知識を持っているため、下流タスク向けの追加訓練はそれほど長く必要ありません。

- 2〜4 epoch 程度が一般的

データ量が少ない場合は、とくに過学習が早く始まるため、短い訓練で十分になることが多いです。

モデルのどこまでを更新するか(凍結戦略)

BERTの層は前半と後半で性質が異なり、前半はより一般的な言語パターン、後半は文脈的な細かな関係をとらえています。

- データが少ない場合

→ 前半の層を凍結し、後半+タスクヘッドのみを更新

→ 過学習を防ぎつつタスク固有の調整が可能 - データが十分ある場合

→ 全層を更新

→ タスクに特化した最適表現を獲得しやすい

この選択は、データセットサイズや目的に応じて変える必要があります。

より精度を高めるための高度なアプローチ

ドメイン適応のための追加事前学習

特定領域の文章にBERTを最適化する際、下流タスクのファインチューニングに入る前に、同じドメインの未ラベルテキストを用いてMasked Language Modeling(MLM)を再度行うという手法があります。

これを「ドメイン適応事前学習(Domain Adaptive Pretraining)」と呼び、さまざまな研究で有効性が確認されています。

この段階を挟むことで、モデルが扱うテキスト特有の語彙・表現・文構造に適応し、下流タスクでの精度向上が期待できます。

Sentence-BERT(SBERT)による文埋め込み最適化

標準的なBERTは、本来文ベクトル間の“意味的な距離”を最適化する目的では学習されていません。

そのため、文同士の類似度計算などを目的とする場合、標準BERTの [CLS] ベクトルを利用するだけでは満足な結果が出ないことがあります。

これを改善するために設計されたのが Sentence-BERT(SBERT) です。

SBERTは文レベルの意味類似度が反映されるように学習されており、文検索・クラスタリングなどのタスクに適しています。

軽量化・高速化手法の活用

DistilBERT

BERTに対して知識蒸留を用いて軽量化されたモデルで、速度が向上しつつモデルサイズが小さくなる一方、精度低下は比較的緩やかです。

パラメータ効率化学習(LoRAなど)

近年では、巨大モデルの一部分のみを効率的に更新する手法も一般化しつつあり、BERTでも適用可能です。

メモリ使用量・計算コストが小さくなり、少ないリソースでも微調整が行えます。

データ品質がモデル性能に与える影響

BERTは表現力が高いモデルであるため、少量の誤ったラベルやノイズに非常に敏感です。

特に以下のポイントが重要です。

- ラベル付けの一貫性

- データに含まれる文の構造的バラつきの管理

- 不要な文・異常値の除外

表現力が高い分、わずかなデータ品質の問題でも過学習が起こりやすいため、入力データの整備は他モデル以上に重要になります。

まとめ

- BERTは強力な事前学習済みNLPモデルであり、下流タスクにはファインチューニングが不可欠。

- ファインチューニングは「BERT本体+タスク固有ヘッド」を自分のデータに合わせて再学習するプロセス。

- 学習率は極めて低く設定し、エポック数も短めが理想的。

- データ量に応じて層の凍結を調整することで、過学習を防ぎつつ性能を高められる。

- ドメイン適応やSBERTなど、さらに高度なアプローチを組み合わせると性能が大きく向上する。

- データ品質はBERTの性能に強く影響するため、前処理・ラベル整合性が特に重要。

以上、BERTモデルのファインチューニングについてでした。

最後までお読みいただき、ありがとうございました。