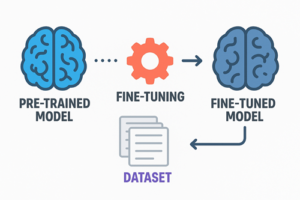

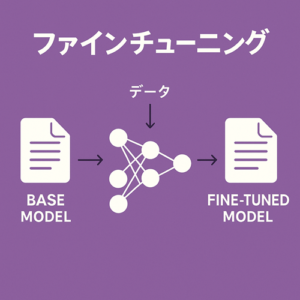

ファインチューニングとは、既に大規模なデータで学習済みのモデルに対して、特定の目的や好みに応じた追加学習を行うプロセスです。

これにより、モデルはより特化した振る舞いを獲得し、既存モデルと比較して一貫性の高い応答を返すようになります。

ファインチューニングは、まるで「汎用的で優秀な人材を、自分のやり方に慣れさせて育てるような作業」に近いものです。

そこには、文体の定着、独自ルールの反映、応答内容の安定化など、多様な目的を達成する力があります。

ファインチューニングを行う目的

ファインチューニングが必要になる場面には、主に以下のような特徴があります。

文体・トーン・書き方を完全に固定したい

通常の指示だけでは文体にある程度の揺れが生じます。

ファインチューニングを行うと、モデルは特定の文体を「標準」として覚えるため、出力が極めて一貫性あるものになります。

特定の知識体系やルールをモデルに深く浸透させたい

細かい表現ルールや、一般的には知られていない独自の知識体系をモデルに直接学習させることができます。

従来であれば毎回プロンプトで細かく指定する必要があった内容を、モデルが「デフォルトのふるまい」として理解するようになります。

特定タスクの再現性を高めたい

決まった形式での応答、あるいはブレが許されない作業において、ファインチューニングは非常に適しています。

モデルは「求められる出力」を例示データから学習し、同じ構造・品質の応答を安定して生成できるようになります。

ファインチューニングで実現できること

ファインチューニングの効果は多岐にわたります。

文体・語彙の統一

一定の書き方を徹底的に学習させることで、長文でも短文でも、常に同じ雰囲気・リズムの文章が出力されます。

応答のブレを最小化

通常のモデルは、プロンプトが少し違うと出力も変化しがちです。

ファインチューニングされたモデルは、安定して似た品質の回答を返すようになります。

特定領域の理解の深さが増す

ある領域の専門的表現、固有ルール、独自概念などを学習させることで、モデルはその領域に特化した応答が可能になります。

作業効率の向上

指示の簡略化により、一度学習させた内容は繰り返し利用でき、作業のばらつきを減らし、品質を均一化できます。

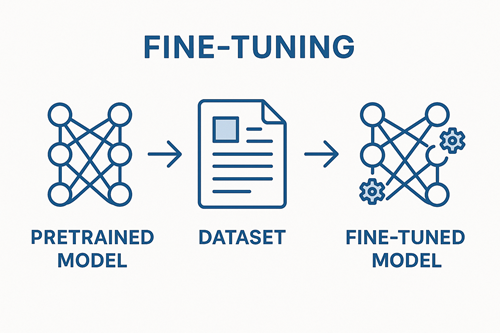

ファインチューニングの仕組み(工程)

ファインチューニングは次のステップで構成されます。

学習データの準備

まずは、モデルに覚えてほしい「理想的な応答例」を多数用意します。

これらの例がそのまま“教師データ”となり、モデルの振る舞いを規定します。

形式としては、1行につき1サンプルの JSONL 形式が用いられ、各データは「ユーザーの入力」と「理想的な回答」のペアで構築されます。

データの品質調整(クレンジング)

データの品質がモデルの品質に直結するため、以下を丁寧に行う必要があります。

- 文体の統一

- 不要な情報やノイズの除去

- 誤字・脱字の修正

- 不適切な応答例が混ざっていないかの確認

質の高いデータほど、より明確で安定したファインチューニング結果につながります。

モデルへの学習実行

準備したファイルを指定して学習ジョブを作成し、モデルが新しい振る舞いを獲得するためのトレーニングを実行します。

内部的には、大規模モデルが示された例を繰り返し読み込み、出力パターンを最適化していきます。

学習後モデルの利用

学習が完了すると、新しい「専用モデル」が生成されます。

以後はそのモデルに対して通常どおり入力を送るだけで、学習で身につけたスタイル・知識・規則が反映された応答が返ってきます。

使用できるファインチューニングの種類

現在のファインチューニングには複数の方式があり、それぞれ特徴が異なります。

Supervised Fine-tuning(教師ありファインチューニング)

もっとも一般的な方式です。

「入力に対する理想の出力」をセットでモデルに与え、望ましい応答の仕方を直接学習させます。

DPO(Direct Preference Optimization)

同じ入力に対して「良い例」と「悪い例」の両方を与え、モデルに「どちらが優れているか」を学ばせる方式です。

文章の好みや判断基準をモデルに反映させたい場合に適しています。

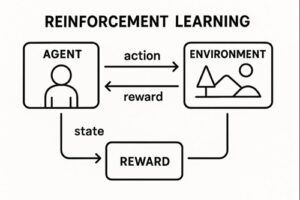

RFT(Reinforcement Fine-tuning)

強化学習の概念を応用した方式で、モデルが生成した応答を別の評価者(LLM ジャッジなど)が採点し、そのスコアをもとにモデルが改善していきます。

高度な最適化が可能ですが、現在は対応モデルが一部に限られています。

データ量に関する考え方

ファインチューニングを行う際のデータ量には次のような指南があります。

- 仕様上の最小:10件以上(最低限の形式として)

- 実際に効果を感じるための目安:100〜1,000件程度

より多くの質の高いデータがあるほど、モデルの再現性と安定性は向上します。

ファインチューニングと他手法の比較

ファインチューニングが絶対的な正解ではなく、目的によっては別の手法が適しています。

システム指示(カスタム指示)

簡単なルールやトーンの設定なら、まずこの方法で十分な場合が多いです。

都度プロンプトで詳細設定を書く必要はありますが、コストはほぼ不要です。

外部データを参照する手法(RAG など)

大量の情報を扱いたい場合は、モデルに覚え込ませるよりも「必要な情報を検索して参照させる」仕組みが適しています。

膨大な資料・ナレッジをすべて学習させる必要はありません。

独自の設定を盛り込んだカスタムモデル(GPTs)

プロンプトの工夫で多様な動作を定義でき、簡易的な専門モデルを作りたい場合には非常に便利です。

ファインチューニングを選択すべき判断基準

以下に該当する場合、ファインチューニングを検討する価値があります。

- 文体・表現方法を完全に固定したい

- 回答の揺れを極限まで減らしたい

- 特定の形式・フォーマットを必ず守らせたい

- 独自の知識やルールを「標準動作」として組み込みたい

- 長期間にわたり安定した応答を必要とする

これらの条件が複数当てはまるほど、ファインチューニングの効果は大きくなります。

まとめ

ファインチューニングとは、モデルを特定用途に最適化し、より一貫した、理想的な応答を返すように育てるプロセスです。

- 文体やルールの固定化

- 独自知識の埋め込み

- 応答の安定化

- 特定タスクへの最適化

こうした目的において、ファインチューニングは最も強力な手段の一つと言えます。

用途や要件に応じて、システム指示や外部検索を併用しながら、最適な方法を選ぶことが重要です。

以上、ChatGPTのファインチューニングについてでした。

最後までお読みいただき、ありがとうございました。