大規模言語モデル(LLM)を活用する場面が増える中で、「ファインチューニング」と「RAG(Retrieval-Augmented Generation)」という言葉をよく耳にするようになりました。

どちらも LLM の性能を高めるための手法ですが、仕組みも役割も大きく異なります。

本記事では、それぞれの特徴とメリット、使い分けの基準まで、専門的な内容を整理しつつ丁寧に解説します。

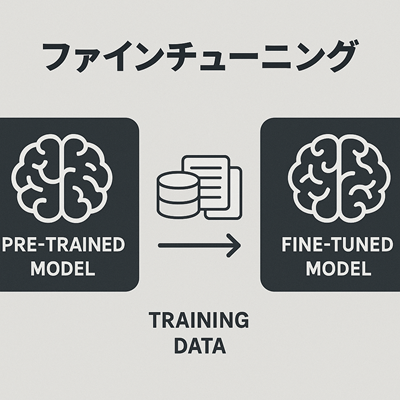

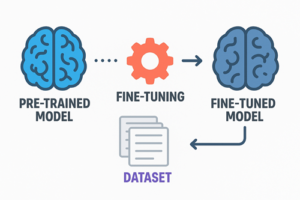

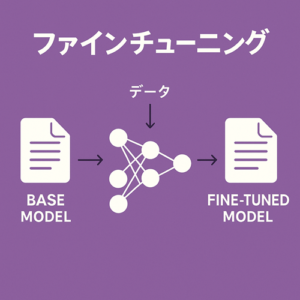

ファインチューニングとは?

ファインチューニングは、既存のLLMに対して追加の学習データを与えることで、モデルのパラメータを更新し、特定のタスクに適応させる技術です。

特徴

- モデル内部のパラメータが書き換わる

- 新しい文体・形式・タスクをモデル自身が「覚える」

- 一度学習した内容を変えるには再学習が必要

- 文体の統一や特定タスクへの最適化に強い

分類や意図判定、特定フォーマットでの回答など、モデルの“挙動そのもの”を変えたい場合に有効です。

ファインチューニングの種類

ファインチューニングには複数の手法があります。

- フル・ファインチューニング:全パラメータを更新する方法

- LoRA / PEFT などの軽量ファインチューニング:

モデル本体を凍結したまま一部の追加層だけを学習させる方法

現在は軽量手法が主流となりつつあります。

RAG(Retrieval-Augmented Generation)とは?

RAGは、外部データベースに保存された文書を検索し、それらを LLM に参照させることで回答を生成する技術です。

LLM 自体は書き換えず、「検索された情報」を材料として文章を生成します。

仕組み

- 入力テキストを元に関連文書を検索(ベクトル検索やキーワード検索)

- 検索結果をコンテキストとしてLLMに渡す

- LLMがそれらを参照して回答を生成する

特徴

- モデルのパラメータは変更されない

- 外部データを差し替えるだけで最新情報を扱える

- 大量の文書を扱える

- 回答品質が検索精度に大きく依存する

RAGは、変化が激しい情報や大量のナレッジを扱う場合に特に効果的です。

ファインチューニングとRAGの違い

両者の違いを表にまとめると、次のようになります。

| 観点 | ファインチューニング | RAG |

|---|---|---|

| モデルパラメータ | 更新される | 更新されない |

| 知識の保持場所 | モデル内部 | 外部データベース |

| 更新方法 | 再学習が必要 | データ差し替えで即反映 |

| 得意分野 | 文体・タスク特化 | 最新情報・大量知識 |

| 依存要素 | 学習データの質 | 検索精度・DB構造 |

簡単に言えば、

- ファインチューニング = モデルを育てる

- RAG = モデルに資料を参照させる

という違いがあります。

どちらを使うべきか?選択の基準

どちらを選ぶべきかは、目的によって明確に分かれます。

ファインチューニングが向いているケース

- モデルに文体や振る舞いを覚えさせたい

- 分類など、タスク特化の処理を学習させたい

- 特定形式(JSONなど)で安定した出力が必要

- 一貫性の高い応答が求められる

RAG が向いているケース

- 最新情報を扱う必要がある

- 文書量が多く、すべてをモデルに覚えさせるのが非効率

- データが頻繁に更新される

- モデル内部を触らずに知識を拡張したい

実は「組み合わせ」がもっとも強い

実際のシステムでは、

- ファインチューニングで”どう答えるか”を調整し、

- RAGで”何を根拠に答えるか”を提供する

という構成がもっとも高い性能を発揮します。

モデルに文体やタスク処理能力を身につけさせ、知識部分は外部データとして最新の情報を参照する。

このような役割分担は非常に合理的です。

まとめ

- ファインチューニングは、モデルの能力・挙動を強化する技術

- RAGは、外部データを参照させて知識を補強する技術

- 両者は競合ではなく、役割が異なる

- 目的によって使い分け、必要に応じて併用すると最も効果的

大規模言語モデルの活用が進む中で、これら二つのアプローチを正しく理解することは、システム設計やサービス開発の質を大きく左右します。

以上、ファインチューニングとRAGの違いについてでした。

最後までお読みいただき、ありがとうございました。