Llama 3 / 3.1 / 3.2 のファインチューニングは、多様な分野で「用途特化の知能をモデルに付与する」ために行われます。

以下では、仕組み・モデル構成・学習方式・データ設計・注意点といった基盤部分に焦点を当てて解説します。

Llama 3 / 3.1 / 3.2 の位置づけ

Llama シリーズは Meta が公開している大規模言語モデル群で、それぞれのバージョンは次のように進化しています。

Llama 3

- 8B / 70B のモデルが提供され、言語理解・生成能力が強化された世代。

Llama 3.1

- 8B / 70B に加えて 405B の大規模モデルが登場し、多言語性能や推論能力が一段と向上。

Llama 3.2

- 主に軽量モデルとビジョン対応モデル(視覚入力を処理可能)を含むライン。

- エッジ用途や低リソース環境に最適化されたバリエーションが多い。

これらはすべて共通して「モデルの重みが公開されている」一方、完全なオープンソースではなく、利用条件を定めたライセンスの下で提供されています。

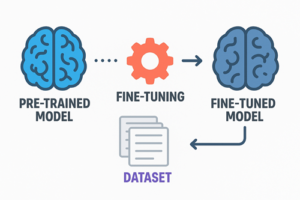

ファインチューニングの方式

ファインチューニングには大きく分けて 2 つの手法があります。

全量学習(Full Fine-Tuning)

モデルのすべてのパラメータを更新する方法。

特徴

- 高い適応性が得られる。

- しかし計算資源とコストが非常に大きい。

- 大規模モデルほど実施が難しく、一般ユーザーが自前で行うケースは限定的。

パラメータ効率化手法(PEFT)= LoRA など

近年主流となっている方式で、モデルの一部のみを追加学習するアプローチ。

特に LoRA(Low-Rank Adaptation) が代表的。

特徴

- モデル本体を大きく変えずに追加パラメータのみを学習させる。

- 計算コストが大幅に下がり、単一 GPU でも扱いやすい。

- 学習済みモデルを複数用途に応用する柔軟性が高い。

多くの現場で採用されているのはこちらで、ほぼ標準的な方法といえます。

ファインチューニング用データの設計

データの質は、ファインチューニングの成否を決める最重要要素です。

一般的なデータ構造(指示追従形式)

用途に応じた形式は複数ありますが、指示を与え、その理想的な応答をセットにした形式が最も広く使われています。

例

- instruction:求めたい挙動の指示

- input:追加情報(必要な場合のみ)

- output:望ましい回答例

この形式は Llama の Instruct モデルと相性が良く、挙動を明確に制御しやすいのが利点です。

データ数の目安

厳密な基準は存在しませんが、実務的な経験則として次のような規模がよく採用されます。

- 少数特化:500〜3,000

- 実用レベルの安定性:5,000〜20,000

- 高度な専門領域:50,000 以上も検討

重要なのは「量より質」であり、曖昧・不統一・ノイズを含むデータは学習結果に強く悪影響を与えます。

モデル選択と環境要件

モデル選択

ファインチューニングを行う際は、ベースモデルよりも Instruct 系モデル(例:Llama-3.1-8B-Instruct)を利用する方が一般的です。

すでに指示追従能力が組み込まれているため、追加学習が効率的になります。

ハードウェア

モデルサイズによって必要な GPU VRAM が変わります。

8B クラス

- 24GB VRAM 以上なら快適

- 量子化やオフロードを用いるとより少ない VRAM でも可能

70B クラス

- LoRA の利用で単体 GPU でも対応可能な場合がある

- ただし、高性能 GPU を推奨

405B クラス

- 一般利用者が自前でファインチューニングする現実性はほぼない

- 専用インフラやクラウド大規模環境が前提

ファインチューニング時の注意点

データの偏りに注意

特定のスタイルや癖を多く含むデータで学習すると、モデル全体がその方向に強く偏る。

過学習の回避

学習をやりすぎると、モデルが柔軟性を失ったり、汎用的な能力を損なったりする。

著作権・ライセンス

権利保護されたデータを無断使用するのは問題となるため、学習データの出典管理が必要。

評価は人間目線で行う

自動指標だけではモデルの品質を測りきれないため、出力の自然さ・安定性・再現性を人の目で確認することが重要。

まとめ

今回の解説は、ファインチューニングのプロセスにおける基礎部分のみを抽出し、技術コードや特定用途の文脈を取り除いて体系的に再構成したものです。

要点としては

- Llama 3 系は複数のバリエーションがあり、用途や環境に応じて適切なモデルを選ぶ必要がある

- ファインチューニングは LoRA などの効率化手法が主流

- データの質が性能を大きく左右する

- モデルのバージョンやライセンス、ハードウェア要件の理解が重要

- 過学習・偏りの管理や人間による評価が不可欠

という点が挙げられます。

以上、Llama3モデルのファインチューニングについてでした。

最後までお読みいただき、ありがとうございました。