Scikit-learnはPythonで書かれたオープンソースの機械学習ライブラリで、線形回帰、ロジスティック回帰、決定木、ランダムフォレストなど、多くの機械学習アルゴリズムの実装を提供しています。

重回帰分析(Multiple Linear Regression)は、これらのアルゴリズムの一つであり、複数の独立変数(説明変数)を使用して、依存変数(目的変数)を予測するモデルです。

このモデルは、独立変数の線形結合を通じて依存変数を予測します。

目次

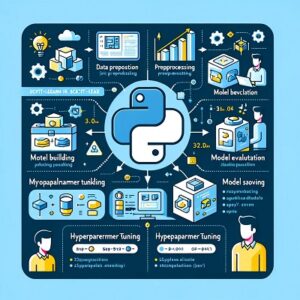

Scikit-learnを使った重回帰分析のステップ

- データの準備: 必要なデータセットを準備し、説明変数と応答変数を定義します。

- データの前処理: データの正規化や標準化などの前処理を行うことが一般的です。これにより、異なるスケールの変数間の比較が容易になります。

- モデルの選択: Scikit-learnでは、重回帰分析には

LinearRegressionクラスが使用されます。 - モデルのトレーニング: トレーニングデータを使ってモデルをトレーニング(フィッティング)します。このステップでは、モデルがデータから係数 β の値を学習します。

- モデルの評価: テストデータを使用してモデルの性能を評価します。一般的な評価指標には、R2スコア、平均二乗誤差(MSE)、平均絶対誤差(MAE)などがあります。

- 予測: モデルを使用して新しいデータの予測を行います。

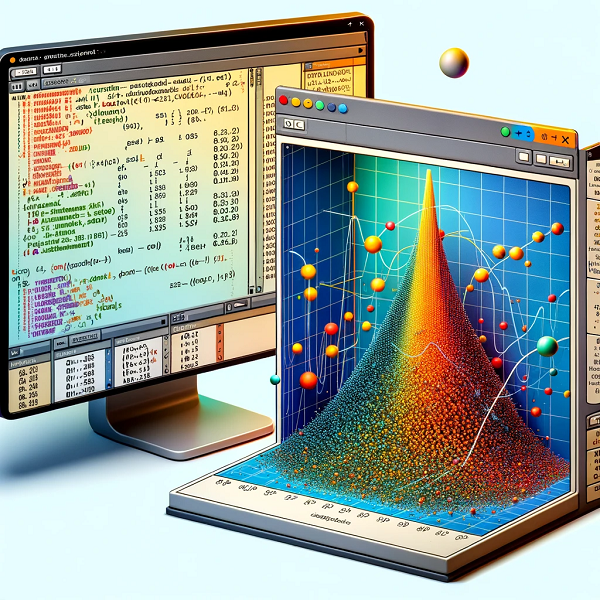

サンプルコード

from sklearn.linear_model import LinearRegression

from sklearn.model_selection import train_test_split

import pandas as pd

# データの準備

data = pd.read_csv('your_dataset.csv')

X = data[['feature1', 'feature2', 'feature3']] # 独立変数

y = data['target'] # 依存変数

# データをトレーニングセットとテストセットに分割

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

# モデルの作成とトレーニング

model = LinearRegression()

model.fit(X_train, y_train)

# 予測

predictions = model.predict(X_test)重回帰分析の考慮点

- 多重共線性:独立変数間に高い相関がある場合、モデルの解釈が難しくなります。この問題を解決するためには、変数選択や正則化手法(リッジ回帰、ラッソ回帰など)を使用します。

- モデルの評価:決定係数(R²)や平均二乗誤差(MSE)などの指標を使用してモデルのパフォーマンスを評価します。

- データの前処理:適切なスケーリング、外れ値の処理、欠損値の処理が重要です。

重回帰分析は、ビジネス、経済、社会科学、医療など多くの分野で利用されており、複数の変数が目的変数にどのように影響を与えるかを理解するのに有効な手段です。

Scikit-learnの実装は使いやすく、多くの実用的な機能を提供しています。

以上、Scikit-learnの重回帰分析についてでした。

最後までお読みいただき、ありがとうございました。