Pythonで行うファインチューニングは、すでに学習済みのモデルをベースとして、自分の目的に合わせて適応させるための追加学習プロセスを指します。

この考え方は、画像、自然言語処理、音声など、さまざまなAI領域で広く共通しており、近年のAI活用における重要な基盤技術になっています。

ファインチューニングとは何か

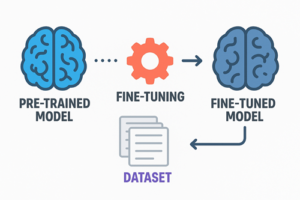

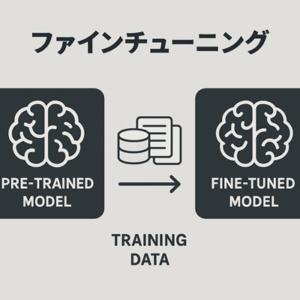

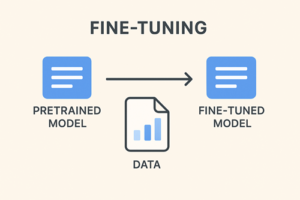

ファインチューニングは、既存の学習済みモデル(pretrained model)が持っている「一般的な知識」を活かしつつ、そこに追加の訓練を行うことで、特定領域の特徴や振る舞いを身につけさせる手法です。

深層学習モデルは、ゼロから学習させようとすると膨大なデータ・計算量・ノウハウが必要になりますが、事前学習済みモデルを起点にすることで、これらを大幅に節約しながら高精度のモデルを作れます。

特に、BERT・GPT系・LLaMA系・ResNet・ViT・Whisper などのモデルは、巨大なデータセットで事前学習されているため、少量の追加データでも目的タスクに適応しやすいという利点があります。

Pythonで利用される主要ライブラリ

Pythonでファインチューニングを行う際に頻繁に利用されるライブラリとして、以下が代表的です。

深層学習フレームワーク

- PyTorch

現代の研究・実務現場で最も広く用いられており、柔軟性に優れています。 - TensorFlow / Keras

産業利用でも歴史がありますが、近年はPyTorchの利用が優勢です。

モデルとデータ管理のためのライブラリ

- Hugging Face Transformers

BERT、T5、GPT系、LLaMA系など多数のNLP・LLMモデルを扱う標準的ライブラリ。 - Hugging Face Datasets

データセットの取り扱い・前処理を効率化します。 - PEFT(Parameter-Efficient Fine-Tuning)

LLM向けの軽量なファインチューニング手法(LoRAなど)を扱うフレームワーク。 - Accelerate / Lightning

GPU・マルチデバイス環境での学習を簡略化するための仕組み。

ファインチューニングの代表的な方法

ファインチューニングには複数のアプローチがあります。

目的、データ量、モデル規模、計算資源によって最適解が異なります。

全層ファインチューニング(フルチューニング)

モデル内部のすべてのパラメータを更新する方法です。

高い適応能力が得られますが、計算コストが大きく、巨大モデルでは非現実的な場合があります。

部分的ファインチューニング

事前学習モデルの一部のみを学習対象にするアプローチです。

例としては

- 出力層(ヘッド)のみ更新する

- 上位層のみ更新し、下位層は固定する

- BatchNorm層の扱いを調整する(固定するか、統計量のみ更新するか)

など、運用の幅があります。

パラメータ効率型ファインチューニング(LoRA / PEFT)

特にLLMでは、この方法が近年のスタンダードになっています。

特徴として

- 元の巨大モデルは固定し、追加の小さな低ランク行列だけを学習する

- 学習済みのLoRA重みは必要に応じて合体(マージ)したり切り替えたりできる

- 学習に必要なGPUメモリが大幅に削減される

多くの個人利用・企業利用で実用的な選択肢になっています。

LLM(大規模言語モデル)のファインチューニングの位置づけ

LLMの学習は、従来のモデルとは比較にならないほど巨大なモデルサイズを扱うため、フルチューニングには何十GB〜数百GBクラスのGPUメモリや分散学習の環境が必要になります。

そのため、一般的な環境では PEFT・LoRA のような軽量チューニング手法が事実上の標準となっています。

LLMのファインチューニングでよく見られる用途には、以下が含まれます。

- 特定の文章スタイル・表現傾向の調整

- 特定ドメインの知識を補完するための追加学習

- 指示追従(Instruction Following)の強化

これらはいずれも Python+Transformers+PEFT の組み合わせで実現可能です。

ファインチューニングにおける重要な実務的ポイント

データ品質の重要性

深層学習において、データの質は結果を左右する最大の要因です。

ノイズの混入やラベルの揺れがあると、そのまま性能に影響します。

少量データであっても、正確で一貫したデータを用意できれば十分に機能するケースも多いです。

過学習への注意

特にデータ量が少ない場合、モデルが「訓練データの丸暗記」をしてしまい、汎用性が下がることがあります。

適切な検証データの分離、早期終了、正則化手法の活用などが重要です。

事前学習タスクと応用タスクの距離

転移学習が成功しやすいかどうかは、「事前学習時に学んだ構造」と「追加学習で求めるタスク」がどれだけ近いかによって大きく左右されます。

例

- BERT → テキスト分類(距離が近い)

- 画像分類モデル → 物体検出(構造が異なるため追加のヘッドが必要)

ファインチューニングを始めるためのステップ

初学者から中級者に向けたベストプラクティスとして、次の流れが一般的です。

- 環境構築

Pythonと必要なライブラリを整え、GPU環境を準備する。 - 事前学習モデルを理解する

自分の目的に合ったモデルを選定し、その構造や入出力の形式を把握する。 - データ整備

クリーンで一貫性のあるデータセットを用意する。 - ファインチューニング手法を選択

- 全層学習

- 一部層だけの更新

- LoRA/PEFT

など、資源と目的に合う方式を決める。

- 評価と改善

適切な評価指標を選び、過学習・再現性に注意しながら精度を引き上げていく。

以上、Pythonによるファインチューニングについてでした。

最後までお読みいただき、ありがとうございました。