大規模言語モデル(LLM)の活用が当たり前になりつつある現在、モデルをどのように自社用にカスタマイズするかは、多くの企業・開発者にとって重要なテーマです。

特に混同されがちなのが、

- ファインチューニング(Fine-tuning)

- 追加学習/継続学習(Continual Learning)

の違いです。

両者は似ているようで、目的・影響範囲・リスク・技術的な背景に明確な違いがあります。

本記事では、その関係性を“誤解のない正確な定義”と“実務で使える理解”の両面から深く掘り下げます。

ファインチューニングとは何か ― 総称としての位置づけ

まず押さえるべき最重要ポイントは、

ファインチューニングとは、事前学習済みモデルのパラメータを追加のデータで更新する行為全般の総称である。

ということです。

この定義には、次のような多様な方法がすべて含まれています。

- フルパラメータファインチューニング

→ すべてのパラメータを更新する最も重い方式 - 部分的ファインチューニング

→ 特定の層やモジュールのみ更新 - PEFT(パラメータ効率化ファインチューニング)

→ 代表例:LoRA、QLoRA、Adapter、Prefix Tuning など

→ “学習する部分だけを小さくし、ベースモデルはほぼ固定する”軽量手法

つまり、実務でよく使われる LoRA も立派なファインチューニングの一種です。

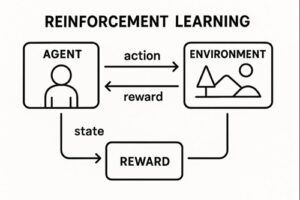

追加学習(継続学習)とは何か ― 時系列更新という文脈

一方の 追加学習(Continual Learning) とは、

時間を分けて新しいデータを追加し、モデルを段階的に学習させていく手法設定のこと。

特徴としては、

- 一気に大きく特化させるのではなく

- 新しい情報やドメイン知識を少しずつ加えていく

- しかし“忘却(Catastrophic Forgetting)”が起きる可能性がある

という性質があります。

よって、「追加学習」はファインチューニングと競合する概念ではなく、むしろ“ファインチューニングをどのように適用するか”という文脈に属すると考えたほうが正確です。

両者を混同しやすい理由と、正しい区別のしかた

一般には、次のように語られることが多く、これが誤解の原因になっています。

- ファインチューニング

→ 性格やスタイルまで変える“大規模なカスタマイズ” - 追加学習

→ 知識の追加・アップデートだけを行う“小規模更新”

この理解はビジネス用途では概念的に分かりやすいものの、技術的には必ずしも正確ではありません。

より正確な整理は以下です。

技術的に正しい違い

| 項目 | ファインチューニング | 追加学習(継続学習) |

|---|---|---|

| 定義 | 追加データでパラメータを更新する行為全般 | 時系列で学習を重ねる設定そのもの |

| 手法 | フル更新、部分更新、LoRAなどすべて含む | 基本的には「ファインチューニングを繰り返す形」 |

| 目的 | タスク適応・ドメイン最適化 | 知識の追加・更新 |

| リスク | 内容次第で挙動が変質することがある | 忘却問題が起きやすい |

実務でのわかりやすい理解

実務では “厳密さより運用視点”のほうが意味を持つことも多いです。

そこで、業務で使いやすいように両者のニュアンスをまとめ直すとこうなります。

ファインチューニングの実務イメージ

- モデルの書き方・思考プロセス・専門性まで深く変えられる

- カスタムAIライターや特化型アシスタントを作るのに向く

- 企業独自のスタイルやブランドトーンを強制できる

- 訓練の質次第で大きく性能が変わる

「モデルの人格そのものを再教育するイメージ」

追加学習(継続学習)の実務イメージ

- 新商品データの追加

- 最新のFAQ反映

- 新ルールやガイドラインの追加

- 季節キャンペーン情報の更新

など、“既存モデルに新しい知識だけ足したい”場面に最適です。

「モデルに追加の授業を受けさせるイメージ」

LoRAの位置づけを正しく理解する

前述の通り、LoRA を“追加学習のカテゴリ”として扱う説明を見かけますが、それは学術的には正確ではありません。

- LoRA は Parameter-Efficient Fine-Tuning(PEFT) の一種

- つまり、ファインチューニングの中に内包される手法

そして実務的には、

- ベースモデルを壊しにくい

- コストが安い

- 複数タスク用のアダプタを切り替え可能

という大きな利点から「安全な追加知識強化」に使われやすい。

この“運用上のイメージ”が、LoRA を“追加学習”と誤解させる背景になっています。

まとめ

最後に最も正確で誤解のない整理を示します。

ファインチューニング(Fine-tuning)

追加データを用いて、モデルのパラメータを調整・更新する手法全般の総称。

フル更新・部分更新・LoRAなどすべて含む。

追加学習(継続学習・Continual Learning)

新しいデータを時系列で与えて順次モデルを更新していく設定。

技術的にはファインチューニングを繰り返す形と考えられる。

以上、ファインチューニングと追加学習の違いについてでした。

最後までお読みいただき、ありがとうございました。