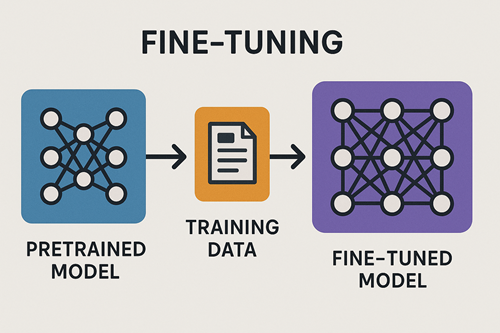

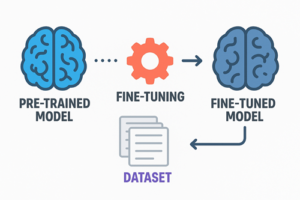

Unsloth は、大規模言語モデル(LLM)のファインチューニングを従来より高速化し、必要メモリを大幅に削減しつつ、品質を落とさないという目的で開発された最適化ライブラリです。

特に、近年主流である LoRA / QLoRA(低精度量子化 + アダプタ学習) の学習プロセスを高度に最適化しており、

- 2〜5倍の高速化

- 約50〜80%のメモリ削減

- パフォーマンスを維持したままの軽量学習

が一般的な特徴として知られています。

これにより、個人レベルでも比較的大きなモデルを扱いやすくなり、実験・研究・業務応用におけるハードルが大きく下がっています。

なぜ Unsloth は高速・省メモリなのか

Unsloth が従来のファインチューニングより優れている理由は、単一の技術ではなく、複数の要素が密接に組み合わさる点にあります。

4bit 量子化を中心とした高効率なモデル圧縮

モデルを 4bit に量子化することで、計算量とVRAMを大幅に削減します。

- フル精度モデルよりも軽量

- 少ないメモリで推論・学習が可能

- 計算負荷の低減による高速化

一般的な QLoRA と同じコンセプトですが、Unsloth はこの処理の効率が高いためモデルのロードや学習工程がスムーズに動作します。

GPU向けに最適化された Triton カーネル

Unsloth では、GPU の並列計算性能を最大限に引き出すために、Triton によるカスタムカーネルが用いられています。

- 行列演算の並列化最適化

- メモリアクセスの効率化

- 量子化された重みに適した演算処理

これらは Transformers ベースの標準実装よりも軽量で効率的なことが多く、速度向上と省メモリの両方に寄与します。

手書きバックプロパゲーションによる無駄の排除

Unsloth は一部の勾配計算処理を手書き実装しています。

- 中間テンソルの削減

- 不要な計算の排除

- メモリ使用量の抑制

これにより、バックプロパゲーションの負荷が小さくなり、学習速度が向上します。

モデル読み込みの高速化

量子化モデルの読み込みプロセスを効率化することで、大きなモデルでも初期化が短時間で完了します。

結果として、モデル訓練の全体的なワークフローがスムーズになります。

対応モデルの広さと機能拡張

Unsloth は初期には QLoRA の高速化ライブラリとして認識されていましたが、現在では対応領域が大きく拡張されています。

対応している代表的なモデル

- Llama ファミリー(Llama 2, Llama 3, Llama 3.1)

- Mistral / Mixtral

- Gemma

- Qwen / DeepSeek

- Phi

- BERT 系のエンコーダモデル

- TTS(音声)、Vision(画像)モデル

さらに、最新のモデルにも比較的早い段階で対応する傾向があります。

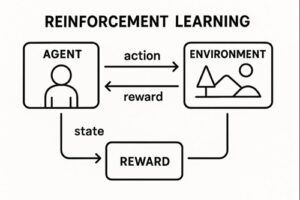

ファインチューニング以外の機能

- RL(強化学習):GRPO, DAPO など

- Low-Rank Adaptation(LoRA・QLoRA)

- マルチ GPU・高速分散学習

- 長文入力(Long-context)対応モデルへの拡張

単なる量子化ライブラリを超え、LLM トレーニングの総合的な高速化基盤となりつつあります。

Unsloth で実施できるファインチューニング手法

SFT(Supervised Fine Tuning)

最も一般的な教師あり学習方式で、入力とそれに対応する理想的な出力のペアを大量に学習させます。

SFT の用途例には

- 文体・文構造の学習

- タスク特化型の回答精度向上

- 既存の業務手順や定義済みルールの反映

などがあります。

DPO(Direct Preference Optimization)

複数の候補回答のうち、「どちらが望ましいか」という比較情報を学習させるファインチューニング手法です。

DPO は SFT では学習できない「選好性(品質の良し悪し)」を直接モデルに反映できるため、

- 出力の自然さ

- 一貫した表現傾向

- 良質な応答への誘導

といった改善が行いやすくなります。

Unsloth は TRL(Hugging Face の RL ライブラリ)と統合されているため、DPO やその他の Preference-based Learning を効率的に実行できます。

RAG(検索拡張生成)とのハイブリッド運用

外部データを柔軟に参照する必要がある場合は、RAG(Retrieval-Augmented Generation)と組み合わせることで、

- 大規模データを丸ごと fine-tuning しなくても済む

- 更新頻度の高い情報に追従できる

- モデルの文体・推論形式だけを SFT で補正できる

といった柔軟なアプローチが可能です。

Unsloth 使用時に押さえるべきポイント

データ品質がアウトプット品質を左右する

高速で学習できるため、少量データでも過学習が起きやすい傾向があります。

そのため、

- ノイズのない高品質な学習データを用意する

- 統一されたフォーマットでデータを整備する

- 評価データも別途用意する

- 過学習を監視し、早期停止や hyperparameter の調整を行う

といった運用が重要です。

モデルサイズとメモリ要件は「原則としてケース依存」

Unsloth は一般的に低VRAMで動作しますが、

- モデルサイズ

- バッチサイズ

- シーケンス長

- LoRA ランク

などによって必要VRAMは変動します。

「13B が 8GB で必ず動く」などの断定的な記述は正確ではなく、VRAM要件は条件により大きく変わる点は理解しておく必要があります。

Unsloth は Transformers 互換であるが独自仕様も存在する

Transformers の使用経験があるほど扱いやすいものの、

- 一部の API

- 設定項目

- Trainer の構成方式

- モデルのロードパラメータ

などは Unsloth 独自または強化版となっています。

そのため、実装時は公式ドキュメントに従うことが推奨されます。

まとめ

Unsloth は、以下のような特徴を持つ非常に実用的なファインチューニング基盤です。

- 高速(2〜5倍)

- 省メモリ(50〜80%削減)

- LoRA / QLoRA の高度最適化

- 幅広いモデルラインナップに対応

- SFT・DPO・RL など多様な学習手法を実装可能

- 個人レベルでも比較的大規模なモデルを扱える

LLM の実験・開発・カスタムモデル構築の効率を大幅に向上させるツールとして、現在最も注目される選択肢のひとつといえるでしょう。

以上、Unslothによるファインチューニングについてでした。

最後までお読みいただき、ありがとうございました。