Meta AI が公開した Segment Anything Model(SAM) は、画像内のあらゆる対象を「点」「ボックス」「既存マスク」などのプロンプトから瞬時に切り出せる、革新的なセグメンテーションモデルです。

ゼロショットでも高精度なため、汎用モデルとして幅広く活用できますが、特定業界ではそのままでは精度が不足するケースも少なくありません。

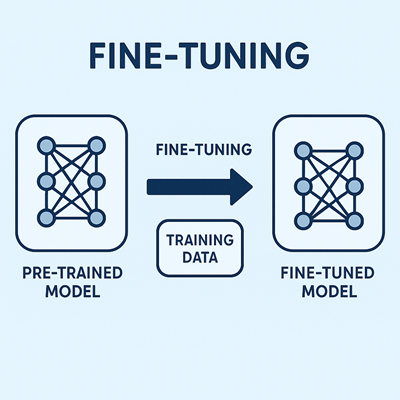

そこで重要になるのが SAM のファインチューニング(微調整) です。

本記事では、SAMの内部構造から微調整方式、必要なデータ、実務的ワークフロー、導入時の注意点までを総合的に解説します。

SAMの基本構造:なぜ微調整が効くのか?

SAM は大きく次の3つのモジュールで構成されています。

Image Encoder

Vision Transformer を用いて画像全体を高次元特徴へ変換する、SAMの中核となる部分。

Prompt Encoder

ユーザーが与える「点」「ボックス」「マスク」といった指示を埋め込み表現に変換。

Mask Decoder

画像特徴とプロンプト情報を統合し、目的の領域マスクを生成する最終ステージ。

SAM の本質は、「プロンプト条件付きのセグメンテーションモデル」という点にあります。

つまり、何を切り出すかをプロンプトで指定し、それを手がかりに対象物のみを抽出する仕組みです。

SAMのファインチューニング方法は3タイプ

SAMは巨大なモデルであるため、微調整にも複数のレベルがあります。

最適な方法は用途とリソースによって異なります。

方式①:Mask Decoder のみを微調整(最も現実的でよく使われる)

SAMの Image Encoder は凍結し、最終段階である Mask Decoder のみを学習対象にする方式です。

【特徴とメリット】

- GPUメモリ消費が少なく、一般的な環境でも学習が可能

- 元々の汎用性を損なわず、目的領域に特化させられる

- データ量が少ない場合でも効果が出やすい

【よく使われる領域】

- EC 商品画像の背景除去

- 医療画像の特定部位の境界抽出

- 工業製品の部品識別

- 農作物・雑草分類などの農業AI

「まずこれを試すべき」と言える、現実的なアプローチです。

方式②:LoRA / PEFT を利用した軽量微調整

巨大モデルの課題である「メモリ負荷」と「学習コスト」を解決するのが、LoRA(Low-Rank Adaptation)などの軽量ファインチューニング手法です。

【メリット】

- 元モデルの重みを保持したまま追加パラメータだけを学習

- 極めて軽量で、カスタム用途への展開が容易

- モバイル推論や省メモリ実行にも適している

【利用例】

- マシンパワーが限られた企業環境

- さまざまなドメインに迅速に適応したい研究機関

- エッジデバイス向け推論の最適化

汎用性と低コストを両立したアプローチのため、近年急速に普及しています。

方式③:Image Encoder まで含むフルチューニング(最高精度を狙う時)

SAMを最深部から作り変える方法で、最も高い学習効果があります。

【向いている状況】

- 医療 CT・MRI、顕微鏡映像など、事前学習データと分布が大きく異なる画像

- 衛星画像や赤外線映像など特殊ドメイン

- トップレベルの精度が必要な研究開発

【注意点】

- GPU 40〜80GB級を推奨とする非常に高いリソース要求

- 大量の教師データが必要

- 学習コストが最も高い

“究極の精度”が求められる場合だけ選択されます。

SAMのファインチューニングに必要なデータ

SAMの学習には「正解マスク(GTマスク)」が必須です。

形式は次のようなものが一般的です。

画像データ

JPG / PNG など

マスクデータ

- PNG形式

- COCO形式(polygon / RLE)

- 単一クラス・多クラスどちらにも対応

プロンプト情報(推奨)

SAMは本来「プロンプトで対象物を指定するモデル」のため、学習時にも 点・ボックス・既存マスクなどを模擬的に生成し、入力として与える ことで性能が向上します。

GTマスクを持っているだけでも学習可能ではありますが、プロンプトをモデルに学習させる方が、実務では明確に安定した精度が得られます。

SAMファインチューニングの正しいワークフロー

データ準備

- COCO形式への変換

- マスク品質の検証

- データ拡張(反転・色変化・クロップ)

学習設計のポイント

- Batch size は VRAM に応じて調整(一般に 4〜16)

- 学習率は小さめが安定(1e-4〜1e-5)

- 評価は IoU や Dice 係数を併用

- プロンプトのサンプリングが精度に大きく影響する

SAMが活躍する実務シナリオ

EC・広告クリエイティブ制作

背景除去、髪の毛や衣服の精密切り抜きなど、画像生成AIの前処理として非常に相性が良い。

製造業の外観検査

部品形状の抽出や、傷・欠陥の領域検出など。

少量データでも性能が安定しやすいのがSAMの強みです。

医療画像解析

臓器や腫瘍の領域抽出など、境界精度が極めて重要なケースで活用。

動画処理

SAM単独では動画には非対応ですが、専用トラッカーと組み合わせることで、動画中の物体追跡にも応用できます。

導入時の注意点

プロンプトなし学習は安定しにくい

“SAMはプロンプト条件付きモデル”であるため、学習時にプロンプト入力を模倣しないと精度が低下しがちです。

マスク品質が性能を左右する

境界のブレやアノテーションの不均一さは、SAMの精度に直結します。

ドメイン特化しすぎると汎用性が損なわれる

特定領域のデータだけで学習すると、ゼロショット性能が低下する場合があります。

GPU負荷が高い

- Decoderのみ → 軽量

- LoRA → 中程度

- 全層 → 重量級

用途に応じて無理のない設計が重要です。

まとめ:SAMの微調整は目的に合わせて最適化する時代へ

SAMのファインチューニングは、次の3段階で考えると明確になります。

- Mask Decoder だけ調整する軽量方式

→ 最も現実的で多くの現場に適用しやすい - LoRA を使った軽量・高速なパラメータ更新

→ GPUが弱くても十分な精度向上を狙える - Image Encoder まで含めたフルチューニング

→ 特殊ドメインで最大の性能を求める場合

さらに、「プロンプトを学習に含めること」「高品質なアノテーションを用意すること」がSAMチューニング成功の核心になります。

SAMはセグメンテーション技術の新しい基準となりつつあり、正しく微調整できれば、幅広い産業分野で劇的な効率化を実現できます。

以上、SAMによるファインチューニングについてでした。

最後までお読みいただき、ありがとうございました。